Red Hat AI

红帽 AI

为您的企业构建 AI

利用您拥有的资源和独到的洞察,在充分自由的环境下,实现 AI 价值。

红帽® AI 赋能企业,构建并运行满足自身独特需求的 AI 解决方案,从初步试验到全面投入生产,一路相伴。

企业级 AI:灵活赋能,随需而变

为了在混合云中获享一致体验,您需要一个能够在数据存储位置灵活部署的平台。

借助红帽 AI,您可以全面掌控生成式 AI 和预测性 AI 的功能,无论是在云端、本地部署环境,还是在边缘环境中。

借助红帽 AI,您能够自由选择模型和加速器,在实现快速、可扩展推理的同时保持灵活性。

红帽 AI 包括:

红帽® AI 推理服务器可优化混合云中的模型推理,实现更快、更具成本效益的模型部署。

它由 vLLM 提供支持,并且支持访问 Hugging Face 上经过验证和优化的第三方模型。此外,红帽 AI 推理服务器还内置 LLM Compressor 工具。

红帽企业 Linux® AI 是一个用于推理和训练大语言模型的平台,可为企业应用赋能。

该平台包含用于定制模型的 InstructLab 工具,以及集成的硬件加速器。

+ 包括红帽 AI 推理服务器

红帽 OpenShift® AI 基于红帽 OpenShift 的功能打造而成,为大规模管理生成式 AI 和预测性 AI 模型的生命周期提供了一个平台。

该平台通过集成的 MLOps 和 LLMOps 功能,提供涵盖混合云环境中 AI 应用分布式训练、调优、推理及监控的完整生命周期管理解决方案。

+ 包括红帽 AI 推理服务器

+ 包括红帽企业 Linux AI

利用 InstructLab 在本地自定义 LLM

红帽的 InstructLab 是一个社区驱动的项目,旨在让更多开发者能够轻松体验 IBM 的 Granite 模型,即使他们不具备深厚的机器学习背景。

无论您是想体验自己选择的 AI 模型,还是在本地硬件上微调基础模型,这里都是一个很好的起点。

它消除了试验 AI 模型的成本和资源限制,让您在将 AI 技术应用于企业之前,可以充分进行探索和验证。

广结 AI 盟友,共拓未来之路

专家和技术汇聚一堂,助力我们的客户在 AI 领域创造更多价值。众多技术伙伴与红帽携手合作,以确保其产品与我们的解决方案兼容并经过认证。

解决方案模式

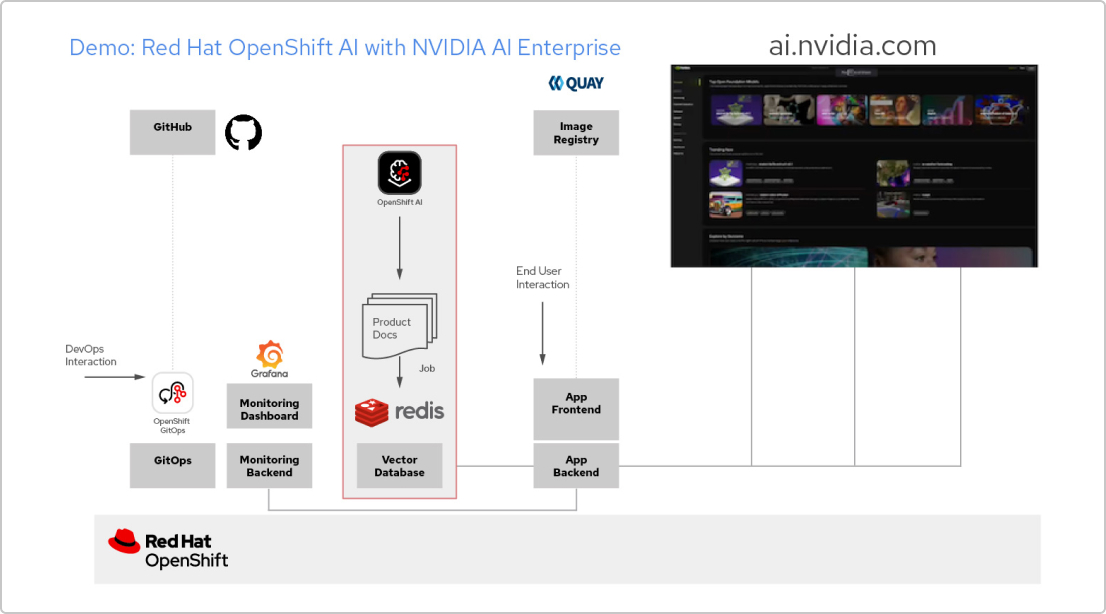

使用红帽技术和 NVIDIA AI Enterprise 构建的 AI 应用

创建 RAG 应用

红帽 OpenShift AI 是一个用于构建数据科学项目并为依托 AI 的应用提供服务的平台。您可以集成支持 检索增强生成(RAG)所需的所有工具,这是一种从自己的参考文档中获取 AI 答案的方法。将 OpenShift AI 与 NVIDIA AI Enterprise 关联后,您可以尝试各种 大语言模型(LLM),以找到适用于您应用的最佳模型。

构建文档处理管道

要使用 RAG,首先需要将文档导入到一个向量数据库中。在示例应用中,我们将一组产品文档嵌入到 Redis 数据库中。由于这些文档经常更改,我们可以为此过程创建一个管道并定期运行,以确保始终拥有最新版本的文档。

浏览 LLM 目录

NVIDIA AI Enterprise 支持访问不同 LLM 的目录,因此您可以尝试不同的选择,并选取能够提供最佳效果的模型。这些模型托管在 NVIDIA API 目录中。设置 API 令牌后,您就可以直接从 OpenShift AI 使用 NVIDIA NIM 模型服务平台来部署模型。

选择合适的模型

在测试不同的 LLM 时,您可以让用户对每个生成的响应进行评分。您还可以设置一个 Grafana 监控面板,用于比较各个模型的评分、延迟和响应时间。然后,您就可以根据这些数据来选择最适合在生产环境中使用的 LLM。