Künstliche Intelligenz (KI) trägt zu Innovationen bei, indem sie Unternehmen hilft, ihre Daten besser zu nutzen und so wertvolle Erkenntnisse zu gewinnen. Unternehmen führen KI-Anwendungen schnell ein, aber Entwicklung, Training und Verwaltung von KI-Workloads in großem Umfang bleiben eine Herausforderung. Models as a Service (MaaS) hilft bei der Bewältigung dieser Herausforderung, indem es Unternehmen ermöglicht, KI-Modelle als skalierbare Dienste zu operationalisieren.

Was ist Models as a Service (MaaS)?

Models as a Service (MaaS) hilft Unternehmen, die Wertschöpfung zu beschleunigen und Ergebnisse schneller zu erzielen. MaaS stellt vortrainierte KI-Modelle über ein API Gateway auf einer Hybrid Cloud-KI-Plattform zur Verfügung.

MaaS kann von spezialisierten internen Teams entwickelt und bereitgestellt und für den Rest des Unternehmens verfügbar gemacht werden. So können andere Teams schneller und effizienter arbeiten und sich auf strategisch wichtigere Aufgaben konzentrieren, indem sie über die APIs auf diese vortrainierten Modelle zugreifen. Alternativ können Unternehmen MaaS auch von einem vertrauenswürdigen Anbieter beziehen, wodurch sich der Aufbau eines eigenen MaaS-Teams erübrigt. Neben Effizienz und Kosteneinsparungen bietet MaaS Ihrem Unternehmen auch mehr Kontrolle über den Datenschutz, die Daten und deren Nutzung.

Wann ist MaaS sinnvoll?

Die Verwaltung von GPUs und der zugrunde liegenden KI-Infrastruktur erfordert qualifizierte Mitarbeitende, die KI-Modelle entwickeln, trainieren und verwalten.Statt einfach nur KI-Infrastructure as a Service (IaaS) anzubieten, kann ein Unternehmen eine kleine Anzahl qualifizierter Fachleute mit Entwicklung, Training und Bereitstellung von KI-Modellen beauftragen, die Mitarbeitende im Unternehmen nutzen können.

Mit zunehmender Nachfrage nach Modellinferenzaufrufen können das zugrunde liegende Serving Framework und die GPUs leichter skaliert werden, um die Anforderungen zu erfüllen. MaaS-Anbieter übernehmen auch die gesamte Wartung und Überwachung der Infrastruktur, einschließlich Updates, Performance und Sicherheit.

Außerdem ist es wichtig zu beachten, dass GPUs teuer sind und ihr ineffizienter Einsatz die Kosten in die Höhe treiben kann. MaaS verringert die Notwendigkeit umfangreicher Investitionen in die Infrastruktur und hilft Unternehmen, Vorlaufkosten zu senken.

Auch die Wertschöpfung ist wichtig, und MaaS trägt dazu bei, den ROI (Return on Investment) eines Unternehmens zu beschleunigen. Entwicklung und Training eines Modells sind sehr zeitaufwendig. MaaS trägt dazu bei, die Wertschöpfung zu beschleunigen, da die Modelle den Teams, die sie nutzen wollen, sofort zur Verfügung stehen.

MaaS

Versuchen wir, MaaS und seine Kernkomponenten mittels eines übergeordneten Konzepts zu verstehen. Zu den wichtigsten Komponenten von MaaS gehören die Modelle, eine skalierbare KI-Plattform, ein KI-Orchestrierungssystem und ein robustes API-Management.

Wenn es um MaaS geht, ist die Wahl eines auf die Use Cases Ihres Unternehmens zugeschnittenen KI-Modells nur ein Teil des Puzzles. Mit dem Modell ist noch viel mehr verbunden, wie Datenerfassung, Überprüfung, Ressourcenmanagement sowie die für die Bereitstellung und Überwachung der Modelle erforderliche Infrastruktur.

In der Welt der KI-Anwendungen werden solche Aktivitäten im Rahmen von MLOps (Machine Learning Operations) automatisiert. MLOps umfasst den gesamten Lifecycle eines KI-Projekts mit DevOps-ähnlichen Aufgaben innerhalb eines funktionsübergreifenden Teams. Im Falle eines MaaS-Lifecycles verfügt der MaaS-Anbieter über ein ähnliches funktionsübergreifendes Expertenteam, darunter Data Scientists, ML-Engineers und IT-Operations, die bei der Bereitstellung und Verwaltung des MaaS-Angebots zusammenarbeiten.

Modelle

Der MaaS-Anbieter ist für die Entwicklung des Modellkatalogs verantwortlich und bezieht Open Source-, Drittanbieter- oder eigene Modelle ein. Je nach den Anforderungen des Unternehmens kann der MaaS-Anbieter die Modelle mithilfe von Tuning-Techniken wie Fine Tuning anpassen oder dank RAG (Retrieval Augmented Generation) oder RAFT (Retrieval Augmentation with Fine Tuning) ein besseres Benutzererlebnis bieten. Nach der Anpassung wird das Modell gespeichert und seine Metadetails in der Modell-Registry abgelegt, sodass es für die Bereitstellung verfügbar ist. Der MaaS-Anbieter kann auch einen Modellkatalog mit den verfügbaren Modellen erstellen und diesen sowie die offengelegten APIs in einem Entwicklerportal dokumentieren.

Red Hat OpenShift AI

Die Basis von MaaS ist die KI-Plattform, mit der die Modelle abgestimmt, bereitgestellt und überwacht werden. Der MaaS-Anbieter ist dafür verantwortlich, dieses System mit geeigneten Tools für die Überwachung zu versehen.

Er muss Modelle effizient bereitstellen, mehrere Mandanten verwalten, Sicherheitsbedrohungen überwachen und beseitigen und verschiedene Datenquellen integrieren.

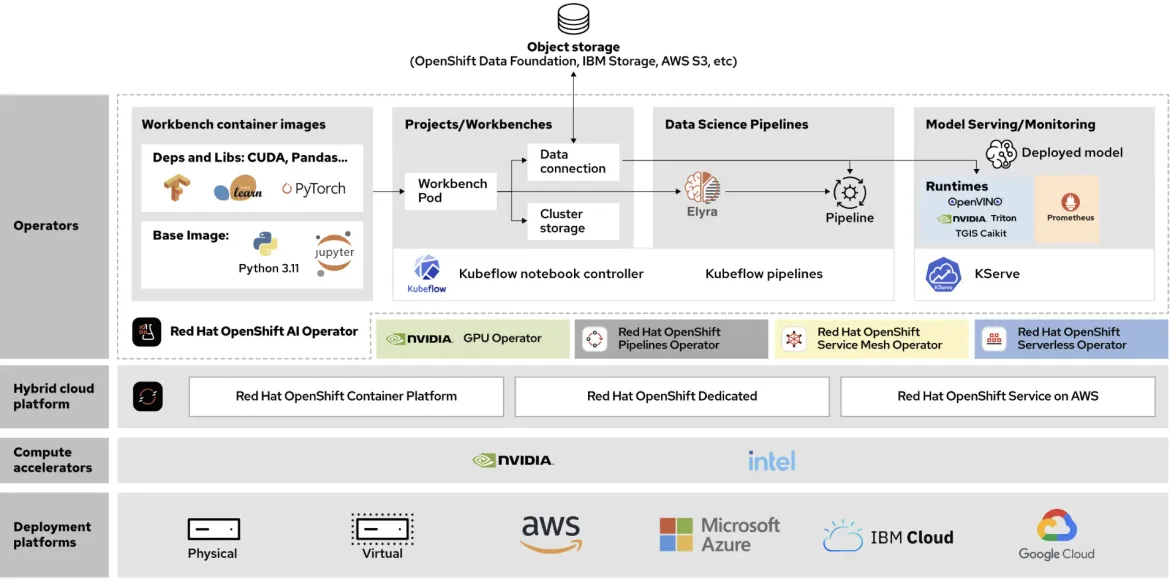

In unserem Konzept setzen wir Red Hat OpenShift AI als KI-Plattform ein, da es die Anforderungen von MaaS erfüllt und Funktionen wie Mandantenfähigkeit, robuste Sicherheitsvorkehrungen für die Modellbereitstellung und die Integration mit Datenservices bietet. OpenShift AI optimiert die Workflows für Dateneingabe, Modelltraining, Modellbereitstellung und Beobachtbarkeit und ermöglicht eine nahtlose Zusammenarbeit zwischen den Teams.

Vorteile von Red Hat OpenShift AI

OpenShift AI bietet eine Reihe von Vorteilen für Unternehmen, die ein MaaS-System einrichten wollen, darunter:

- Effiziente Skalierung zur Bewältigung der Anforderungen umfangreicher KI-Workloads

- Ausführen von KI-Workloads in der Hybrid Cloud, einschließlich Edge- und getrennten Umgebungen

- Integrierte Authentifizierung und RBAC (Role Based Access Control)

- Zahlreiche Funktionen zur Bewältigung der Anforderungen an Sicherheit und Compliance

Darüber hinaus ist OpenShift AI modular aufgebaut, sodass Ihr MaaS-Team einen kundenspezifischen KI/ML-Stack erstellen und bei Bedarf Partner- oder andere Open Source-Technologien einbinden kann.

KI-Orchestrierung

Darüber verfügt Red Hat OpenShift AI über Funktionen zur KI-Orchestrierung, die es MaaS-Anbietern ermöglichen, mit verschiedenen Versionen desselben Modells oder sogar mit verschiedenen Modellen für einen bestimmten Use Case zu experimentieren und diese besser zu steuern. Einer der Hauptzwecke der KI-Orchestrierung besteht in der Weiterleitung der API-Anfragen an die korrekte Modellinstanz. Diese Schicht kann auch zusätzliche Komponenten zur Verwaltung verschiedener Techniken für das Modell-Tuning enthalten.

API-Management

Das API-Management ist eine der wichtigsten Komponenten beim MaaS-Design. MaaS-Anbieter müssen in der Lage sein, den Zugriff zu verwalten, Anwendungen einzubinden, Analysen bereitzustellen und Rückerstattungen zu berechnen, damit Kunden ihre Anwendungen verwalten und beobachten sowie den ROI effektiv messen können. Das API-Management ermöglicht außerdem umfassende Onboarding- und Nutzungsrichtlinien und bietet ausgefeilte Analysen zur Nutzung, Über- und Unterbeanspruchung sowie den potenziellen Missbrauch veröffentlichter APIs.

Es bietet Support für Hochverfügbarkeit (HA), Datenverkehrskontrolle, API-Authentifizierung, Integration mit dritten Identity Providers, Analytik, Zugriffskontrolle, Monetarisierung und Entwicklungs-Workflows.

Intelligente Anwendungen

Verbraucheranwendungen wie Chatbots, mobile Anwendungen oder ein Portal bilden die letzte Komponente in dieser Architektur. Die wichtigsten Stakeholder sind hier die Entwicklungsteams, die die verfügbaren KI-Modelle über die vom MaaS-Anbieter veröffentlichten APIs in ihre intelligenten Anwendungen integrieren wollen. Diese Teams sollten ihre Anwendungen integrieren und die API-Verwaltungsfunktionen über ein spezielles Entwicklerportal nutzen können.

So können die Entwicklungsteams Nutzende mit intelligenten Anwendungen versorgen, die sich über ihre APIs nahtlos in die Modelle integrieren lassen. Damit können sich die Entwicklungsteams auf die Lösung geschäftlicher Probleme mithilfe der vorgefertigten Modell-APIs konzentrieren, während sich der MaaS-Anbieter um die Modelle, MLOps und die zugrunde liegende Infrastruktur kümmert.

Fazit

Durch Abstrahieren der Komplexität von Infrastruktur und Data Science können Unternehmen MaaS nutzen, um KI-Lösungen schneller und effizienter bereitzustellen und gleichzeitig die Kontrolle über Kosten und Komplexität von MLOps zu behalten.

Angesichts der täglich zunehmenden Nutzung von KI ist MaaS ein großartiger Ansatz zur Beschleunigung der KI-Entwicklung und der Markteinführungszeiten. Erkunden Sie die Möglichkeiten von Red Hat OpenShift AI und erfahren Sie, wie wir Sie beim Aufbau Ihres MaaS-Angebots unterstützen und Sie so das volle Potenzial Ihrer KI-Investitionen ausschöpfen können.

product trial

Red Hat OpenShift AI (selbst gemanagt) | Testversion

Über den Autor

Muhammad Bilal Ashraf (preferred name: Bilal) is a Senior Architect at Red Hat, where he empowers organizations to harness the transformative potential of open-source innovation. Since joining Red Hat in 2021 as a Cloud Native Architect, Bilal has advanced to his current role, collaborating closely with customers and partners to deliver strategic value through cloud-native solutions, AI/ML, and cutting-edge technologies. His expertise lies in architecting scalable, open-source-driven solutions to accelerate digital transformation, optimize operations, and future-proof businesses in an evolving technological landscape. Bilal’s work bridges the gap between enterprise challenges and open-source opportunities, driving customer success through tailored AI and cloud-native strategies.

Mehr davon

Nach Thema durchsuchen

Automatisierung

Das Neueste zum Thema IT-Automatisierung für Technologien, Teams und Umgebungen

Künstliche Intelligenz

Erfahren Sie das Neueste von den Plattformen, die es Kunden ermöglichen, KI-Workloads beliebig auszuführen

Open Hybrid Cloud

Erfahren Sie, wie wir eine flexiblere Zukunft mit Hybrid Clouds schaffen.

Sicherheit

Erfahren Sie, wie wir Risiken in verschiedenen Umgebungen und Technologien reduzieren

Edge Computing

Erfahren Sie das Neueste von den Plattformen, die die Operations am Edge vereinfachen

Infrastruktur

Erfahren Sie das Neueste von der weltweit führenden Linux-Plattform für Unternehmen

Anwendungen

Entdecken Sie unsere Lösungen für komplexe Herausforderungen bei Anwendungen

Virtualisierung

Erfahren Sie das Neueste über die Virtualisierung von Workloads in Cloud- oder On-Premise-Umgebungen