-

Produkte & Dokumentation Red Hat AI

Eine Plattform für Produkte und Services zum Entwickeln und Bereitstellen von KI in der Hybrid Cloud

Red Hat AI Inference Server

Optimieren Sie die Modellperformance mit vLLM für schnelle und kosteneffiziente Inferenz in großem Umfang.

Red Hat Enterprise Linux AI

Entwickeln, testen und nutzen Sie generative KI-Modelle zur Unterstützung von Unternehmensanwendungen.

Red Hat OpenShift AI

Entwickeln und implementieren Sie KI-gestützte Anwendungen und Modelle in großem Umfang in hybriden Umgebungen.

-

Lernen Grundlagen

-

KI-Partner

Red Hat AI Inference Server

Red Hat® AI Inference Server optimiert Modellinferenz in der Hybrid Cloud und ermöglicht schnellere, kostengünstige Modellbereitstellungen.

Was ist ein Inferenzserver?

Ein Inferenzserver ist die Software, die es KI-Anwendungen ermöglicht, mit LLMs (Large Language Models) zu kommunizieren und auf der Grundlage von Daten eine Antwort zu generieren. Dieser Prozess wird als Inferenz bezeichnet. Dies ist der Punkt, an dem das zu liefernde Ergebnis und damit der Geschäftswert entstehen.

Für eine effiziente Funktion benötigen LLMs viel Speicherplatz, Arbeitsspeicher und eine umfassende Infrastruktur, um Inferenzen in großem Umfang zu ermöglichen. Daher kann dies den Großteil Ihres Budgets in Anspruch nehmen.

Als Teil der Red Hat AI Plattform optimiert Red Hat AI Inference Server die Inferenzfunktionen, um die ansonsten hohen Kosten und die umfangreiche Infrastruktur zu reduzieren.

Einführung zu Red Hat AI Inference Server

Wie funktioniert Red Hat AI Inference Server?

Red Hat AI Inference Server ermöglicht schnelle und kostengünstige Inferenzen in großem Umfang. Dank des Open Source-Charakters werden beliebige gen KI-Modelle (generative KI) auf verschiedenen KI-Beschleunigern und in beliebigen Cloud-Umgebungen unterstützt.

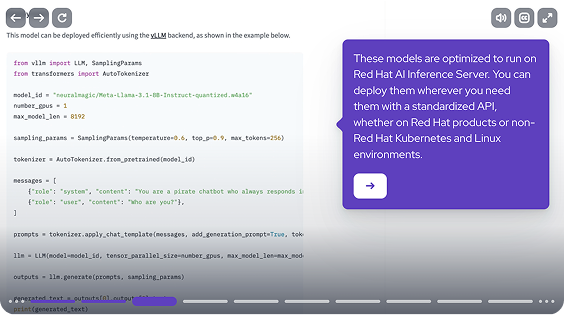

Der auf vLLM basierende Inferenzserver maximiert die GPU-Auslastung und ermöglicht schnellere Antwortzeiten. In Kombination mit LLM Compressor wird die Inferenzeffizienz ohne Einbußen bei der Performance gesteigert. Durch die plattformübergreifende Anpassungsfähigkeit und eine wachsende Mitwirkung der Community entwickeln sich vLLMs zum Linux® im Bereich der gen KI-Inferenz.

50 % Einige Kunden, die LLM Compressor eingesetzt haben, konnten 50 % der Kosten einsparen, ohne Abstriche bei der Performance hinnehmen zu müssen.*

* Zelenović, Saša. „Unleash the full potential of LLMs: Optimize for performance with vLLM.“Red Hat Blog, 27. Feb. 2025.

Ihre Modelle – Ihre Wahl

Red Hat AI Inference Server unterstützt führende Open Source-Modelle und gewährleistet eine flexible GPU-Portabilität. Sie erhalten die Flexibilität, beliebige gen KI-Modelle zu verwenden und aus unserer optimierten Sammlung von validierten Open Source-Modellen von Drittanbietern auszuwählen.

Darüber hinaus ist Red Hat AI Inference Server als Teil von Red Hat AI für die Produkte von Red Hat zertifiziert. Es kann auch auf anderen Linux- und Kubernetes-Plattformen eingesetzt werden, die im Rahmen der Support-Richtlinie für Drittanbieter von Red Hat unterstützt werden.

Red Hat AI Support

Als einer der größten kommerziellen Mitwirkenden an vLLM verfügen wir über ein umfassendes Verständnis dieser Technologie. Unsere KI-Consultants verfügen über die vLLM-Expertise, um Sie beim Erreichen der KI-Ziele in Ihrem Unternehmen unterstützen zu können.

Kauf

Red Hat AI Inference Server ist als Standalone-Produkt oder als Teil von Red Hat AI verfügbar. Die Software ist in Red Hat Enterprise Linux® AI und in Red Hat OpenShift® AI enthalten.

Deployment mit Partnern

Fachleute und Technologien werden zusammengeführt, damit unsere Kunden mit KI mehr erreichen können. Sehen Sie sich die Partner an, die mit Red Hat zusammenarbeiten, um ihre Kompatibilität mit unseren Lösungen zu zertifizieren.

Häufig gestellte Fragen

Muss ich Red Hat Enterprise Linux AI oder Red Hat OpenShift AI erwerben, um Red Hat AI Inference Server verwenden zu können?

Nein. Sie können Red Hat AI Inference Server als ein Standalone-Produkt von Red Hat erwerben.

Muss ich Red Hat AI Inference Server erwerben, um Red Hat Enterprise Linux AI verwenden zu können?

Nein. Red Hat AI Inference Server ist beim Kauf von Red Hat Enterprise Linux AI und Red Hat OpenShift AI enthalten.

Kann Red Hat AI Inference Server unter Red Hat Enterprise Linux oder Red Hat OpenShift ausgeführt werden?

Ja, das ist möglich. Im Rahmen unserer Vereinbarung mit Drittanbietern kann es auch auf Linux-Umgebungen von Drittanbietern ausgeführt werden.

Welche Kosten fallen für Red Hat AI Inference Server an?

Die Kosten werden pro Beschleuniger berechnet.