Red Hat AI Inference Server

Red Hat® AI Inference Server は、ハイブリッドクラウド全体でモデル推論を最適化し、より迅速でコスト効率の高いモデルのデプロイメントを可能にします。

推論サーバーとは

推論サーバーはソフトウェアであり、これによって、人工知能 (AI) アプリケーションが大規模言語モデル (LLM) と通信し、データに基づいて応答を生成します。このプロセスを推論と呼びます。このプロセスを通して、ビジネス価値が生み出され、最終結果が提供されます。

LLM が効果的に機能するには、推論を大規模に実行するための大がかりなストレージ、メモリー、インフラストラクチャが必要なため、予算のほとんどはここに費やされます。

Red Hat AI プラットフォームに含まれる Red Hat AI Inference Server は、推論機能を最適化し、従来は避けられなかった高いコストと大規模なインフラストラクチャを削減します。

Red Hat AI Inference Server の概要

Red Hat AI Inference Server の仕組み

Red Hat AI Inference Server は、大規模な推論を高速かつコスト効率よく実行します。オープンソースなので、AI アクセラレーターやクラウド環境を選ばず、あらゆる生成 AI モデルをサポートできます。

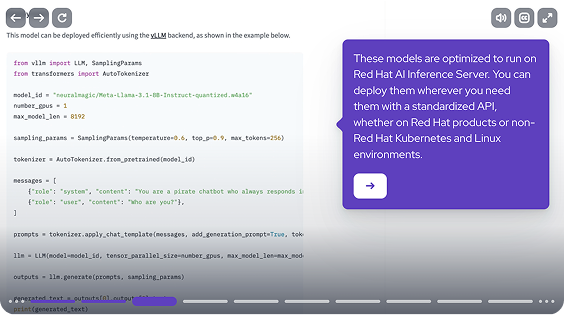

vLLM を搭載した推論サーバーは、GPU の使用率を最大化し、応答時間を短縮します。LLM Compressor 機能と組み合わせることで、パフォーマンスを損なうことなく推論効率が向上します。vLLM は、クロスプラットフォームに対応していることと、コントリビューターのコミュニティが拡大していることから、生成 AI 推論の Linux® として存在感を高めつつあります。

50% LLM Compressor を使用した一部のお客様は、パフォーマンスを損なうことなく 50% のコスト削減を実現しました。*

*Zelenović, Saša、「LLM の潜在能力を最大限に引き出す:vLLM でパフォーマンスを最適化」、Red Hat ブログ、2025 年 2 月 27 日。

組織に適したモデルを選択可能

Red Hat AI Inference Server は、主要なオープンソースモデルをすべてサポートし、さまざまな GPU に対応しています。あらゆる生成 AI モデルを柔軟に使用でき、検証済みでオープンソースのサードパーティモデルの中から最適化されたモデルを選択できます。

さらに、Red Hat AI Inference Server は Red Hat AI の一部なので、すべての Red Hat 製品に対して認定されています。また、Red Hat のサードパーティ・サポート・ポリシーに基づいて、他の Linux および Kubernetes プラットフォームにもデプロイし、サポートを受けることができます。

Red Hat の AI サポート

vLLM への最大コントリビューター企業の 1 社である Red Hat は、このテクノロジーを深く理解しています。vLLM の専門知識を備えた当社の AI コンサルタントが 、企業の AI 目標の達成をお手伝いします。

購入方法

Red Hat AI Inference Server はスタンドアローン製品として、または Red Hat AI の一部として利用可能です。Red Hat Enterprise Linux® AI と Red Hat OpenShift® AI の両方に含まれています。

パートナーとデプロイする

エキスパートとテクノロジーが組み合わさることで、AI 活用の幅が広がります。Red Hat と連携し、Red Hat ソリューションとの相互運用性に関する認定を受けているすべてのパートナーをご覧ください。

よくある質問 (FAQ)

Red Hat AI Inference Server を使用するには、Red Hat Enterprise Linux AI または Red Hat OpenShift AI を購入する必要がありますか。

いいえ。Red Hat AI Inference Server はスタンドアローンの Red Hat 製品として購入できます。

Red Hat Enterprise Linux AI を使用するには、Red Hat AI Inference Server を購入する必要がありますか。

いいえ。Red Hat Enterprise Linux AI または Red Hat OpenShift AI を購入すると、Red Hat AI Inference Server が含まれています。

Red Hat AI Inference Server は Red Hat Enterprise Linux または Red Hat OpenShift で実行できますか。

はい、できます。また、サードパーティ契約に基づき、サードパーティの Linux 環境でも実行できます。

Red Hat AI Inference Server の価格はどのように設定されていますか。

価格はアクセラレーターごとに設定されています。