Una plataforma abierta para los modelos de IA en la nube híbrida

Adopción de las aplicaciones inteligentes y la IA generativa

La inteligencia artificial (IA), el machine learning (aprendizaje automático) y el deep learning (aprendizaje profundo) influyen considerablemente en las iniciativas de modernización de las aplicaciones en una infinidad de sectores y negocios. La necesidad de generar innovaciones, obtener valor estratégico y adquirir información nueva a partir de los datos está fomentando el aumento del uso de las metodologías de MLOps y de las aplicaciones de la nube que implementan la inteligencia artificial. Al mismo tiempo, este nuevo mundo tecnológico puede ser complejo e influir en todos, desde los equipos de desarrollo hasta los de análisis de datos y de operaciones. La puesta en funcionamiento de inteligencia artificial/machine learning no es sencilla, ya que suele demorar meses, mientras que las innovaciones de la inteligencia artificial generativa progresan todos los días. Esta falta de correspondencia puede generar fallas en los proyectos y poner en riesgo a la empresa al exponerla a una gran cantidad de desafíos:

- Puede ser desalentador tratar de seguir el ritmo del progreso de la inteligencia artificial, debido a que las herramientas y los servicios de aplicaciones se deben mantener actualizados y uniformes, a pesar de su rápida evolución. Además, es necesario implementar recursos de hardware, como las unidades gráficas de procesamiento (GPU), y ajustar las aplicaciones que utilizan la inteligencia artificial.

- Las empresas deben reducir los riesgos cuando invierten en la inteligencia artificial y, al mismo tiempo, deben obtener valor, especialmente cuando introducen datos confidenciales en los modelos y las aplicaciones.

- El mantenimiento de distintas plataformas por parte de los desarrolladores de aplicaciones y los analistas de datos puede dificultar la colaboración y ralentizar el desarrollo.

- La implementación de las aplicaciones que utilizan la inteligencia artificial debe realizarse a gran escala y cerca de los puntos de generación de datos.

Red Hat OpenShift AI se basa en Red Hat® OpenShift®, una plataforma líder de aplicaciones de nube híbrida y parte de la cartera de productos de Red Hat AI. Ofrece a los analistas de datos y los desarrolladores una plataforma potente de inteligencia artificial/machine learning para desarrollar e implementar aplicaciones inteligentes. Las empresas pueden probar diversas herramientas, colaborar y agilizar la comercialización, todo desde un mismo lugar. Red Hat OpenShift AI combina el entorno de autoservicio que buscan los analistas de datos y los desarrolladores con la seguridad que exige la TI empresarial.

Los inconvenientes que surgen a lo largo del ciclo de vida se reducen gracias al uso de una base confiable. Red Hat OpenShift AI ofrece una plataforma sólida, un ecosistema amplio de herramientas certificadas y cargas de trabajo conocidas para la implementación de modelos en la etapa de producción. Gracias a estas ventajas, los equipos pueden colaborar con menos contratiempos y comercializar las aplicaciones que usan la inteligencia artificial de manera más eficiente, lo cual genera más ganancias para la empresa.

Aspectos destacados

Reduzca los costos del paso de la etapa de prueba a la de producción al ajustar y automatizar la infraestructura.

Aumente la eficiencia operativa de inteligencia artificial/machine learning en todos los equipos con una experiencia del usuario uniforme que fomente la colaboración entre los analistas, los ingenieros de datos, los desarrolladores de aplicaciones y los equipos de DevOps.

Obtenga la flexibilidad de la nube híbrida al desarrollar, entrenar, implementar y controlar las cargas de trabajo de inteligencia artificial/machine learning en las instalaciones, la nube o el extremo de la red.

Desarrollo, entrenamiento, pruebas e implementaciones ágiles

Red Hat OpenShift AI es una plataforma de inteligencia artificial flexible y con capacidad de ajuste que incluye herramientas para diseñar, implementar y gestionar las aplicaciones que utilizan la inteligencia artificial. Está diseñada con tecnologías de open source y proporciona funciones confiables y uniformes en términos operativos para que los equipos realicen pruebas, pongan los modelos a disposición en la etapa de producción y distribuyan aplicaciones innovadoras. También agiliza la distribución de las aplicaciones inteligentes, puesto que permite que los modelos de machine learning se integren desde los primeros pilotos a las aplicaciones inteligentes de forma más rápida en una plataforma uniforme y compartida.

Además, ofrece una experiencia integrada de interfaz de usuario con herramientas para desarrollar, entrenar, ajustar, implementar y controlar los modelos de inteligencia artificial predictiva y generativa. Puede implementar los modelos en las instalaciones o en las principales nubes públicas, lo cual le brinda la flexibilidad requerida para ejecutar las cargas de trabajo donde sea necesario, sin depender de una nube comercial. Red Hat OpenShift AI se basa en el proyecto de la comunidad Open Data Hub y en los proyectos open source comunes, como Jupyter, Pytorch, modelos de lenguaje de gran tamaño virtuales (vLLM) y Kubeflow.

Reducción de los costos para realizar ajustes en la producción

OpenShift AI es un complemento de Red Hat OpenShift y ofrece una plataforma diseñada para gestionar las cargas de trabajo más exigentes. Reduce los costos corrientes del entrenamiento, la puesta a disposición en la producción y la infraestructura de los proyectos de inteligencia artificial generativa y predictiva a medida que pasan de la etapa de prueba a la de producción. Esto se logra al simplificar la implementación de los recursos y automatizar varias tareas mediante los canales de datos. También disminuye los gastos de las inferencias de los modelos con motores de puesta a disposición en la producción y tiempos de ejecución optimizados, como los vLLM, además del ajuste de la infraestructura fundamental según lo requiera la carga de trabajo.

Los analistas de datos pueden utilizar herramientas y marcos conocidos o acceder a un ecosistema de partners tecnológicos cada vez más grande para disfrutar de una experiencia de inteligencia artificial/machine learning más profunda, todo sin tener que lidiar con una cadena de herramientas prescriptiva. En lugar de esperar a que la TI proporcione los recursos necesarios mediante una solicitud, obtienen acceso a la infraestructura con un solo clic.

Menor complejidad operativa

Red Hat OpenShift AI ofrece una experiencia del usuario uniforme que impulsa a los analistas de datos, los ingenieros de aplicaciones y de datos y los equipos de DevOps a colaborar para distribuir soluciones de inteligencia artificial oportunas de manera efectiva. Ofrece acceso de autoservicio a los flujos de trabajo colaborativos, agilización mediante el acceso a las GPU y operaciones optimizadas. Las empresas pueden distribuir soluciones de inteligencia artificial de manera uniforme a gran escala en los entornos de nube híbrida y en el extremo de la red.

Debido a que OpenShift AI es un complemento de Red Hat OpenShift, las operaciones de TI ofrecen configuraciones más sencillas para los analistas de datos y los desarrolladores de aplicaciones en una plataforma estable y de eficacia comprobada, cuya capacidad se puede ampliar o reducir fácilmente. El control y la seguridad ya no son una prioridad para la TI, por lo que no se encarga de buscar cuentas de plataformas de nube no autorizadas.

Mayor flexibilidad en la nube híbrida

Red Hat OpenShift AI brinda la capacidad de entrenar, implementar y controlar cargas de trabajo de inteligencia artificial/machine learning en un entorno de nube, en centros de datos locales o en el extremo de la red, cerca de donde se generan o se ubican los datos. Esta flexibilidad permite que evolucionen las estrategias de inteligencia artificial al trasladar las operaciones a la nube o al extremo de la red, según sea conveniente. Las empresas pueden entrenar e implementar modelos y aplicaciones que usan la inteligencia artificial donde lo necesiten para cumplir con los requisitos normativos, de seguridad y de datos, lo que incluye a los entornos asilados y los desconectados.

Cuando se preguntó qué áreas tecnológicas recibirían un aumento de fondos en 2025, el 84 % eligió a la inteligencia artificial, en comparación con el 73 % del año anterior1.

Red Hat OpenShift AI

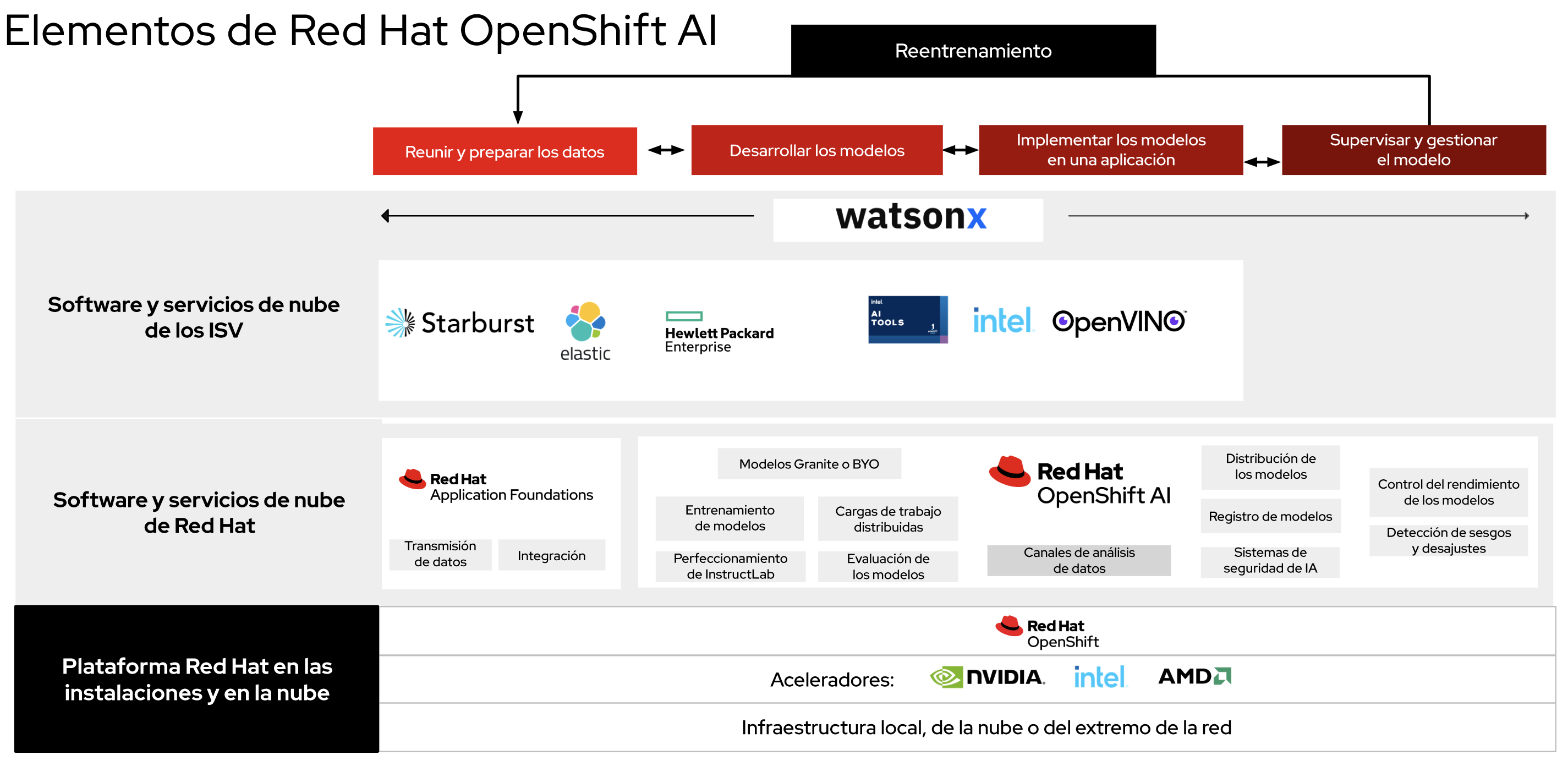

En la figura 1, podemos ver la manera en la que el ciclo de vida operativo del modelo se integra con OpenShift AI como una plataforma común, lo cual amplía las funciones de la plataforma de aplicaciones líder, Red Hat OpenShift. Las empresas dependen de una plataforma de nube híbrida de eficacia comprobada, que se ofrece como un software tradicional autogestionado o como un servicio de nube gestionado, lo que proporciona una enorme flexibilidad. La versión autogestionada se puede ejecutar en todas las ubicaciones en las que funcione Red Hat OpenShift, ya sea en las instalaciones o en cualquiera de los tres entornos principales de nube pública. La opción de servicio de nube está disponible en Red Hat OpenShift Service on AWS y en Red Hat OpenShift Dedicated (en AWS o Google Cloud Platform).

Además, nuestras soluciones permiten que se expandan las funciones de inteligencia artificial mediante la colaboración con un amplio ecosistema de varios partners de software de inteligencia artificial y de software como servicio (SaaS). Red Hat OpenShift AI es flexible y tiene capacidad de integración, de modo que los clientes pueden crear una plataforma integral de inteligencia artificial/machine learning que se adapte a sus necesidades específicas.

Para quienes recién comienzan con los modelos de inteligencia artificial generativa, OpenShift AI incluye los elementos de Red Hat® Enterprise Linux® AI, una plataforma de modelos base que permite desarrollar, probar y ejecutar modelos de lenguaje de gran tamaño (LLM) de Granite para impulsar las aplicaciones empresariales. Además de los modelos de Granite que se ofrecen con Red Hat OpenShift AI, el marco admite modelos de HuggingFace, de Stability AI y de otros repositorios.

La plataforma es un elemento fundamental de IBM watsonx.ai, ya que proporciona las herramientas y los servicios esenciales para las cargas de trabajo de inteligencia artificial generativa. Watsonx ofrece un estudio empresarial para que los desarrolladores de inteligencia artificial puedan obtener aplicaciones de esta tecnología casi sin tener que escribir código, con flujos de trabajo fáciles de usar para el desarrollo de modelos y acceso a una biblioteca de modelos base de IBM y modelos open source seleccionados. Red Hat OpenShift y OpenShift AI son requisitos previos técnicos integrados para el software watsonx.

Las funciones y herramientas principales que proporciona Red Hat OpenShift AI tienen una base sólida:

- Diseño y perfeccionamiento de modelos. Los analistas de datos pueden realizar análisis de exploración en la interfaz de usuario de JupyterLab, que ofrece imágenes de notebook listas para usarse con bibliotecas y paquetes comunes de Python, entre los que se incluyen TensorFlow, PyTorchy CUDA. Además, las empresas pueden proporcionar sus propias imágenes personalizadas de notebook, lo que les permite crear notebooks y colaborar en ellos mientras organizan las tareas en proyectos y entornos de trabajo.

- Puesta a disposición de los modelos en la etapa de producción. Red Hat OpenShift AI ofrece varios marcos para el enrutamiento de la puesta a disposición de los modelos en la etapa de producción con el fin de simplificar la implementación del machine learning predictivo o los modelos base en los entornos de producción, independientemente de los requisitos de recursos informáticos. Para las cargas de trabajo de inteligencia artificial generativa, OpenShift AI proporciona inferencias de modelos impulsadas por vLLM, lo cual brinda el mejor rendimiento y eficiencia del sector en los LLM open source más populares. La solución también ofrece flexibilidad y control al permitir que los clientes incluyan y utilicen los tiempos de ejecución que prefieran.

- Canales de análisis de datos. Red Hat OpenShift AI también incluye elementos de canales de análisis de datos que permiten organizar las tareas en canales y crearlos con un frontend gráfico. Las empresas pueden agrupar los procesos como la preparación de los datos, el diseño y la puesta a disposición de los modelos en la etapa de producción.

- Control de los modelos. Red Hat OpenShift AI permite que los usuarios que se dedican a las operaciones puedan supervisarlas y observar los indicadores de rendimiento de los servidores de los modelos y los modelos implementados. Los analistas de datos pueden usar la virtualización lista para usar para los indicadores de rendimiento y de operaciones o integrar los datos con otros servicios de determinación del estado interno de los sistemas.

- Cargas de trabajo distribuidas. Estas cargas permiten que los equipos agilicen el procesamiento de datos junto con el entrenamiento, el perfeccionamiento y la puesta a disposición en la etapa de producción de los modelos. Gracias a esta función, se pueden priorizar y distribuir los trabajos de ejecución, además de optimizar el uso de los nodos. El soporte avanzado para las GPU permite gestionar las exigencias de las cargas de trabajo de los modelos base.

- Detección de sesgos y desajustes. Red Hat OpenShift AI ofrece herramientas para que los analistas de datos controlen si los modelos son justos e imparciales según los datos de entrenamiento y cuando se implementan en situaciones de la vida real. Las herramientas de detección de desajustes incluyen distribuciones de datos de entrada para los modelos de machine learning implementados. Esto permite identificar el momento en el que los datos activos que se usan para la inferencia se alejan considerablemente de aquellos con los que se entrenó el modelo.

- AI Guardrails (versión de prueba). Esta función incluye detectores de entrada para proteger los tipos de interacción que puede solicitar el usuario y detectores de salida para revisar la seguridad de los resultados del modelo. Además, permite filtrar el lenguaje de odio, abusivo o vulgar, información de identificación personal y competitiva y otras limitaciones específicas del área. Ofrecemos un conjunto de detectores, y los clientes pueden agregar los suyos.

- Evaluación de los modelos. Durante las etapas de análisis y desarrollo de los modelos, el elemento de evaluación proporciona información importante sobre la calidad del modelo. Permite que los analistas de datos evalúen el rendimiento de los LLM en varias tareas, como el razonamiento lógico o matemático, el lenguaje natural antagónico y muchos otros. Los indicadores que ofrecemos se basan en los estándares del sector.

- Registro de modelos. Red Hat OpenShift AI ofrece un lugar central donde ver y gestionar los modelos registrados, lo que permite que los analistas de datos compartan, versionen, implementen y controlen los modelos de inteligencia artificial generativa, sus artefactos y los metadatos.

Además de las imágenes de notebook de Jupyter y el generador de Jupyter para implementar imágenes predefinidas o personalizadas de una empresa para los equipos de análisis de datos, OpenShift AI también incluye el plugin de Git para JupyterLab, que agiliza la integración con Git directamente desde la interfaz de usuario. Pandas, scikit-learn y NumPy son otros paquetes de análisis comunes que se proporcionan como parte del producto para simplificar las operaciones y facilitar la puesta en marcha del proyecto con las herramientas adecuadas. El servidor de RStudio (probado y verificado) y VS Code Server también se ofrecen como entornos de desarrollo integrados (IDE) alternativos de JupyterLab, por lo que los analistas de datos tienen más opciones. La interfaz de usuario permite que creen sus propios espacios de trabajo para organizar y compartir sus imágenes de notebooks y sus artefactos como proyectos. También pueden colaborar con otros usuarios.

Para los proyectos de inteligencia artificial generativa, OpenShift AI habilita el entrenamiento distribuido de InstructLab como una versión de prueba de la función. InstructLab es un elemento esencial de Red Hat Enterprise Linux AI. Proporciona herramientas de alineación de modelos para que las empresas perfeccionen de manera más eficiente los modelos de lenguaje más pequeños con sus datos privados, por más que el equipo no tenga experiencia en inteligencia artificial. Red Hat OpenShift AI respalda el perfeccionamiento eficiente de los LLM con las técnicas de adaptación de bajo rango (LoRA) y de adaptación de bajo rango cuantificada (QLoRA) para reducir la sobrecarga informática y el uso de memoria. También admite las integraciones para que sea más sencillo incorporar la información de un texto con las bases de datos vectoriales que se necesitan para la generación aumentada por recuperación (RAG).

Para poner distribuir los modelos de inteligencia artificial predictiva y generativa, es necesario implementar un enfoque flexible. Red Hat OpenShift AI admite varios marcos, y usted puede elegir los servidores de inferencia de modelo único o de varios modelos que se ofrecen o su propio servidor personalizado. La interfaz de usuario de la puesta a disposición de los modelos en la etapa de producción está directamente integrada en el panel de control de Red Hat OpenShift AI y en los espacios de trabajo de los proyectos. Se puede aumentar o reducir la capacidad de los recursos del clúster fundamental en función de lo que exija la carga de trabajo. Para los LLM que requieren la máxima capacidad de ajuste, Red Hat OpenShift AI ofrece una distribución paralela en varios nodos con tiempos de ejecución de vLLM, lo que permite gestionar varias solicitudes en tiempo real.

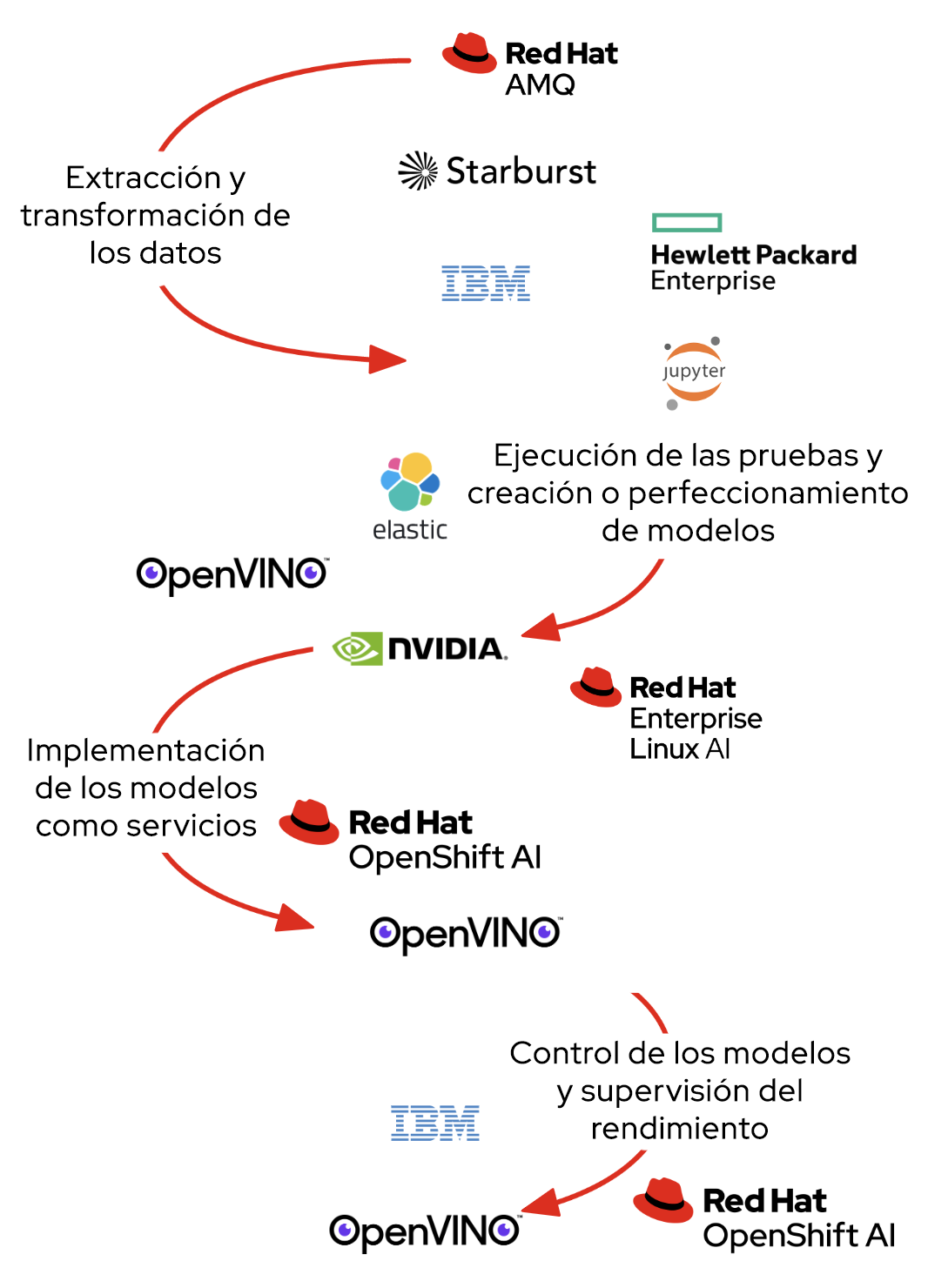

Herramientas para el ciclo de vida completo de la IA

Red Hat OpenShift proporciona los servicios y los sistemas de software que permiten que las empresas entrenen e implementen sus modelos con éxito y los trasladen a la etapa de producción (Figura 2). Este proceso no solo se integra con OpenShift AI, sino también con Red Hat Application Foundations, que incluye Streams for Apache Kafka para la transmisión de datos y eventos en tiempo real, Red Hat 3scale para la gestión de las interfaces de programación de aplicaciones (API) y la compilación de Red Hat de Apache Camel para la integración de los datos.

El panel de control de Red Hat OpenShift AI ofrece un espacio central para descubrir todas las aplicaciones y la documentación y acceder a ellas, lo cual facilita la adopción. Los tutoriales de Smart Start ofrecen orientación en torno a las prácticas recomendadas para los elementos comunes y los sistemas de software de partners integrados. Además, están disponibles directamente desde el panel, lo cual permite que los analistas de datos adquieran la información necesaria y pongan en marcha sus proyectos en menos tiempo. En las siguientes secciones, se describen las herramientas de los partners tecnológicos que se integran con Red Hat OpenShift AI. Algunas requieren una licencia adicional del partner.

Starburst

Starburst agiliza el análisis al permitir que los equipos saquen el máximo provecho de los datos de manera sencilla y rápida para mejorar el funcionamiento de la empresa. Se distribuye como un producto autogestionado o un servicio totalmente gestionado y permite que todos puedan acceder a los datos, de manera que los consumidores posean información más completa. Starburst se basa en Trino (antes conocido como PrestoSQL), el motor principal de SQL de procesamiento paralelo masivo (MPP), que cuenta con tecnología de open source. Esta herramienta, cuyo diseño y operación están a cargo de los especialistas en Trino y los creadores de Presto, permite analizar los distintos conjuntos de datos donde sea que se encuentren, sin tener que trasladarlos.

Se integra a los servicios flexibles de almacenamiento en la nube y cloud computing que ofrece Red Hat OpenShift, lo que le permite consultar todos sus datos empresariales con mayor estabilidad, seguridad, eficiencia y rentabilidad. Estas son algunas de las ventajas que ofrece:

- Automatización. Los operadores de Starburst y Red Hat OpenShift facilitan la configuración, el ajuste y la gestión automáticos de los clústeres.

- Alta disponibilidad y facilidad para reducir los recursos. El equilibrador de carga de Red Hat OpenShift mantiene a ciertos servicios, como el coordinador de Trino, en permanente funcionamiento.

- Capacidad de ajuste flexible. Red Hat OpenShift puede ajustar automáticamente el clúster de trabajo de Trino según la carga de la consulta.

Las empresas necesitan soluciones para la gestión de los datos que ayuden a simplificar todos los procesos, desde las pruebas que se llevan a cabo en las computadoras portátiles hasta las implementaciones empresariales más importantes. HPE Machine Learning Data Management Software (antes conocido como Pachyderm) permite que los equipos de análisis de datos diseñen y ajusten los canales de machine learning basados en los datos y organizados en contenedores con el linaje de datos garantizado que proporciona el control de versiones. Esta herramienta, diseñada para solucionar los problemas reales del análisis de datos, proporciona la base que permite que los equipos automaticen y ajusten su ciclo de vida de machine learning y, al mismo tiempo, garanticen la capacidad de reproducción. Además de los casos prácticos que abarcan desde los datos sin estructurar hasta los almacenes; el procesamiento del lenguaje natural; la extracción, transformación y carga de videos e imágenes; los servicios financieros, y las ciencias biológicas, HPE Machine Learning Data Management Software ofrece:

- automatización del control de versiones de datos que otorga a los equipos una opción de alto rendimiento para seguir los cambios;

- canales organizados en contenedores y basados en los datos que agilizan el procesamiento y, al mismo tiempo, disminuyen los costos informáticos;

- un linaje de datos inmutable que proporciona un registro fijo para todas las actividades y los recursos del ciclo de vida del machine learning;

- una consola que ofrece una visualización intuitiva de los grafos acíclicos dirigidos (DAG) y asiste en las tareas de depuración y reproducción;

- compatibilidad entre los notebooks de Jupyter y la extensión JupyterLab Mount para acceder a una interfaz interactiva con las diferentes versiones de los datos;

- administración empresarial con herramientas sólidas para implementar y gestionar HPE Machine Learning Data Management Software según sea necesario en los distintos equipos dentro de la empresa.

Las plataformas de hardware y software de informática acelerada de NVIDIA agilizan la nueva era

A medida que las aplicaciones de inteligencia artificial/machine learning se vuelven más necesarias para alcanzar el éxito, las empresas precisan plataformas que puedan gestionar las cargas de trabajo complejas, optimizar el uso del hardware y ofrecer capacidad de ajuste. El procesamiento de datos flexible, el análisis de datos, el entrenamiento del machine learning y las inferencias son ejemplos de tareas que utilizan muchos recursos y que son adecuadas para la informática acelerada. El software de NVIDIA AI Enterprise optimiza la implementación de las soluciones de inteligencia artificial en la etapa de producción. NVIDIA NIM, que pertenece a NVIDIA AI Enterprise, es un conjunto de microservicios fáciles de usar que está diseñado para implementar de manera segura y confiable la inferencia de los modelos de inteligencia artificial de alto rendimiento. Mejora la gestión y el rendimiento de estos modelos dentro del entorno de Red Hat OpenShift, lo que permite que las aplicaciones de inteligencia artificial utilicen todo el potencial de la informática acelerada de NVIDIA y del software de NVIDIA AI Enterprise. La combinación de la informática acelerada de NVIDIA, NVIDIA AI Enterprise y Red Hat OpenShift AI permite una mejor asignación de recursos, una mayor eficiencia y una ejecución más rápida de las cargas de trabajo de inteligencia artificial.

Kit de herramientas de Intel OpenVINO

La distribución de Intel del kit de herramientas OpenVINO agiliza el desarrollo y la implementación de las aplicaciones de inferencia de deep learning de alto rendimiento en las plataformas de Intel. El kit permite adoptar, optimizar y perfeccionar prácticamente cualquier modelo de red neuronal y ejecutar inferencias integrales de inteligencia artificial con el ecosistema de herramientas de desarrollo de OpenVINO.

- Modelo. Los desarrolladores de software tienen la flexibilidad de usar sus propios modelos de deep learning. También pueden usar modelos entrenados y optimizados con anterioridad que están disponibles gracias a la colaboración de Intel con Hugging Face para el kit de herramientas de OpenVINO.

- Optimización. El kit de herramientas de OpenVINO ofrece varias maneras de convertir modelos para mejorar la conveniencia y el rendimiento, lo que ayuda a los desarrolladores de software a ejecutar los modelos de inteligencia artificial de modo más rápido y eficiente. Pueden obviar la conversión del modelo y ejecutar la inferencia directamente desde los formatos de TensorFlow, TensorFlow Lite, ONNX o PaddlePaddle. La conversión al formato IR de OpenVINO ofrece máximo rendimiento al reducir el tiempo que demora la primera inferencia y ahorrar espacio de almacenamiento. El marco Neural Network Compression Framework ofrece mayores mejoras.

- Implementación. El motor de inferencia de OpenVINO Runtime es una API que está diseñada para integrarse en las aplicaciones y agilizar el proceso de inferencia. Es un enfoque que se basa en escribir el código una vez e implementarlo en todas partes y permite ejecutar tares de inferencia de manera eficiente en varios sistemas de hardware de Intel, incluidas las unidades centrales de procesamiento (CPU), las GPU y los aceleradores.

Herramientas de IA de Intel®

Las herramientas de inteligencia artificial de Intel (antes conocidas como el kit de herramientas Intel AI Analytics) ofrecen recursos y marcos conocidos de Python a los analistas de datos, los desarrolladores de inteligencia artificial y los investigadores para agilizar los canales integrales de análisis en las arquitecturas de Intel. Los elementos utilizan bibliotecas de oneAPI de Intel para las optimizaciones informáticas de menor importancia. Este kit potencia el rendimiento del procesamiento previo a través del machine learning y ofrece interoperabilidad para un desarrollo de modelos eficiente.

Con las herramientas de inteligencia artificial de Intel puede:

- ofrecer el entrenamiento de deep learning de alto rendimiento en las unidades XPU de Intel e integrar las inferencias rápidas a su flujo de trabajo de desarrollo de inteligencia artificial con los marcos de deep learning optimizados para Intel para TensorFlow y PyTorch, que incluyen modelos entrenados anteriormente y herramientas de baja precisión;

- acelerar de manera instantánea el procesamiento previo de los datos y los flujos de trabajo de aprendizaje automático con los paquetes de Python que consumen muchos recursos informáticos, Modin, scikit-learn y XGBoost, los cuales están optimizados para Intel;

- obtener acceso directo al análisis y las optimizaciones de la inteligencia artificial de Intel para garantizar que su sistema de software funcione en conjunto y sin interrupciones.

Elastic

La plataforma Elastic Search AI Platform, que se basa en ELK Stack, combina la precisión de la búsqueda y con la inteligencia de la IA, lo que permite que los usuarios creen prototipos y realicen integraciones con los LLM más rápido, además de utilizar la inteligencia artificial generativa para diseñar aplicaciones flexibles y rentables. También ayuda a los usuarios a crear aplicaciones de RAG transformadoras, resolver con anticipación los problemas de determinación del estado interno de los sistemas y abordar las amenazas de seguridad complejas. Elasticsearch se puede implementar en donde sea que se encuentren las aplicaciones: en las instalaciones, en el proveedor de nube que elija o en entornos asilados.

Elastic se integra con los modelos del ecosistema, que incluyen Red Hat OpenShift AI, Hugging Face, Cohere, OpenAI y otros, a través de una sola llamada sencilla a la API. Este enfoque garantiza un código claro para gestionar la inferencia híbrida de las cargas de trabajo de RAG con funciones que incluyen:

- fragmentación, conectores y rastreadores web para incorporar distintos conjuntos de datos en la capa de búsqueda;

- búsqueda semántica con Elastic Learned Sparse EncodeR (ELSER), el modelo de machine learning integrado y el modelo de integración E5, lo que habilita la búsqueda vectorial en varios idiomas;

- seguridad en el campo y los documentos con la implementación de permisos y derechos que se ajusten al control de acceso basado en funciones de la empresa.

Con Elastic Search AI Platform, usted forma parte de una comunidad internacional de desarrolladores en la que la inspiración y el respaldo siempre están a mano. Encuentre la comunidad de Elastic en Slack, nuestros foros de debate o nuestras redes sociales.

Conclusión

Gracias a Red Hat OpenShift AI, las empresas pueden probar, colaborar y, finalmente, agilizar su proceso de adopción de aplicaciones que se basan en la inteligencia artificial. Los analistas de datos obtienen flexibilidad al usar esta herramienta como un complemento basado en la nube y gestionado por Red Hat o como una oferta de software autogestionada, lo que simplifica las tareas, independientemente de dónde creen los modelos. Las operaciones de TI se benefician de las funciones de MLOps, lo que permite que los modelos se implementen en producción con mayor rapidez. Las herramientas de autoservicio a las que pueden acceder los desarrolladores y los analistas de datos, que incluyen el acceso a las GPU, agilizan la generación de innovaciones en una plataforma de aplicaciones que la TI empresarial ya utiliza y en la que confía plenamente. A diferencia de los enfoques de la competencia, los analistas pueden elegir las herramientas con las que quieren trabajar, lo cual genera nueva información sin implementar limitaciones arbitrarias.