Em todos os releases das nossas soluções, a equipe de design de experiência do usuário (UXD) da Red Hat prioriza o trabalho de implementação diretamente relacionado ao feedback e aos insights dos clientes. Com uma solução emergente como o RHEL AI, tivemos que usar a criatividade. Para continuar aprimorando o próximo lançamento, usamos canais de feedback, como engajamento da comunidade upstream e comentários dos usuários pelo Slack, entrevistas com membros de equipes internas, entrevistas com usuários de IA e entusiastas que podem ter interesse em adotar o RHEL AI, além da análise da concorrência. Com isso, conseguimos fundamentar nosso trabalho de design do RHEAL AI 1.4 e de releases posteriores.

Temos o prazer de apresentar algumas das principais novas funcionalidades:

- Conversão de documentos: permite a conversão automática de arquivos carregados para markdown. Os usuários agora podem fazer upload de PDFs, HTML, documentos ASCII, entre outros, e eles serão convertidos para markdown.

- Avaliação do modelo de chat: permite que os usuários avaliem as respostas do modelo.

Experiência de contribuição

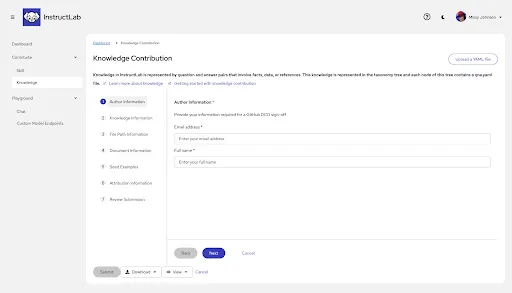

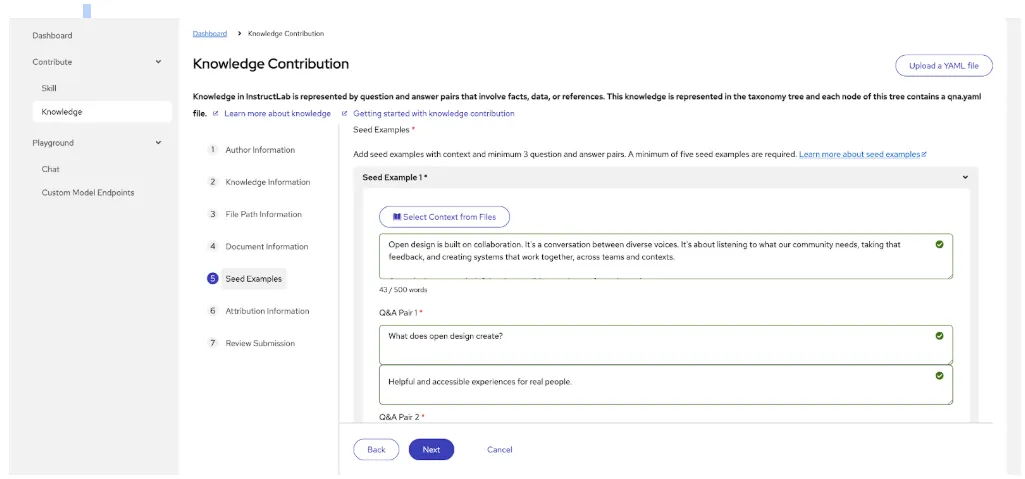

A experiência de contribuição, agora em prévia do desenvolvedor, é uma interface gráfica de usuário (GUI) projetada para ajudar especialistas no assunto a criar informações para o envio de conhecimento sem precisar entender YAML. Isso reduz a barreira de expertise técnica necessária para contribuir com conhecimento e melhorar as respostas do modelo. Para mais contextualização, confira esta publicação incrível no nosso blog, escrita em dezembro por nossos colegas da engenharia.

Discutiremos alguns exemplos específicos de áreas que priorizamos para melhorias na prévia do desenvolvedor.

Conhecimento de formatação

O que ouvimos:

A edição de YAML continua sendo um grande problema, com comentários contínuos da maioria dos usuários destacando pontos desafiadores. É bem difícil para especialistas não técnicos lidarem com isso. A tarefa geral de inserir os dados é complicada e nem sempre fica claro o que é obrigatório e o que é opcional, levando a erros de recuo, espaços em branco etc.

Nossa resposta para o release 1.4:

Continuamos a iterar e melhorar a IU de contribuição de conhecimento, reduzindo pontos de fricção sem afetar as respostas e o desempenho do modelo. Para esta próxima iteração, o UXD recomendou mover a versão longa para um assistente e, assim, orientar os usuários durante o processo e ter certeza de que haverá progresso em cada etapa.

Além disso, ao serem enviados, os documentos são automaticamente convertidos para markdown.

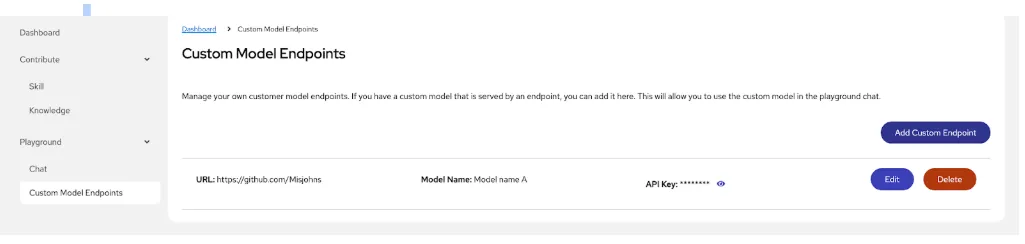

Inclusão de um endpoint para usar um modelo de chat

Para permitir que os usuários usem o chat com modelos próprios, continuamos aprimorando a experiência de endpoint de modelos personalizados.

Para acessar modelos personalizados, os usuários precisam configurar um endpoint dedicado de "chat" na plataforma, assim as mensagens podem ser enviadas em formato de conversa e receber respostas que preservem o contexto durante toda a interação. Para isso, é preciso especificar o modelo desejado, os detalhes de autenticação e a URL do endpoint de API para onde serão enviadas as solicitações de interação no chat.

O que ouvimos:

Em nossa primeira iteração, a lista de endpoints criada (chamada de visualização em lista) não tinha os contextos necessários para os usuários aproveitarem os recursos do endpoint e usar o chat com os modelos personalizados. Além disso, não havia uma conexão clara entre o chat e a experiência do modelo, resultando em solicitações para trabalharmos na união dos fluxos de trabalho.

Melhorias que estamos considerando para o futuro:

- Status de verificação de integridade: inclusão de uma coluna de status de verificação de integridade para ajudar o usuário a identificar rapidamente problemas com a disponibilidade dos endpoints.

- Ações: inclusão de um botão para os usuários ativarem ou desativarem rapidamente a conexão do endpoint. Queremos disponibilizar um menu suspenso com um ícone de três pontos da PatternFly para edição e exclusão.

- Detalhes: inclusão de uma seção lateral que pode ser aberta para a verificação de detalhes adicionais, como a última vez que a chave de API foi alterada ou um link para o caminho de taxonomia.

- URL: inclusão de um ícone de cópia para o usuário copiar rapidamente a URL.

- Classificação padrão: inclusão da possibilidade de classificar pelas criações mais recentes na parte superior.

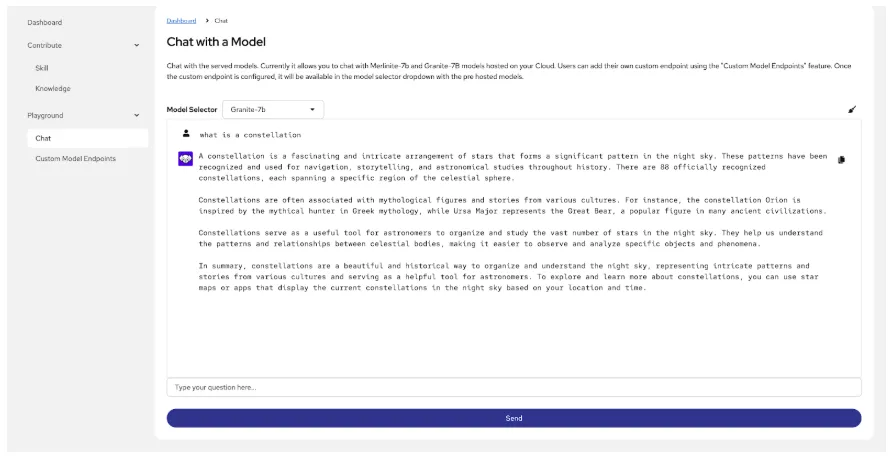

Chat com um modelo

Há muitos momentos na experiência onde um usuário pode querer usar um modelo no chat. Por exemplo:

- Para entender melhor as lacunas nas respostas do modelo, respondendo à pergunta: "O modelo tem os dados que procuro?"

- Para comparar as respostas do modelo de base com as respostas do modelo personalizado, respondendo à pergunta: "Eu melhorei o modelo?"

Por fim, um usuário pode querer comparar um modelo de base, um modelo personalizado com os recursos de ajuste fino do InstructLab e um modelo com ajuste fino do InstructLab combinado com nossos recursos de RAG.

O que aprendemos:

A primeira iteração era uma experiência de chatbot muito básica, sem a possibilidade de visualizar informações de origem e agir conforme as respostas do modelo, além de ser isolada do fluxo de trabalho do endpoint do modelo. Também faltava acessibilidade de voz para texto.

Nossa resposta para o release 1.4:

As melhorias na interface do chat incluem a possibilidade de adicionar um endpoint de modelo personalizado diretamente desse fluxo de trabalho.

Melhorias que estamos considerando para o futuro:

- Possibilidade de revisar as origens usadas para a resposta do modelo e realizar ações (curtir, descurtir, copiar, fazer download e gerar novamente)

- Uso de áudio para criar uma mensagem em vez de inseri-la manualmente

- Mais ajuda contextual

O que vem por aí?

Estamos preparando muitas melhorias interessantes e novas funcionalidades:

- Treinamento e geração de dados sintéticos

- Comparação entre o modelo com ajuste fino recente e o modelo de base

- Ajuste completo de ponta a ponta sem uso de uma interface de linha de comando (CLI)

Entre em contato

Estamos sempre expandindo e aprimorando os recursos do RHEL AI pensando nos clientes em primeiro lugar. Acompanhe os próximos releases para conferir mais melhorias. Inscreva-se para participar de pesquisas futuras e compartilhar suas experiências com o RHEL AI.

Além disso, entre na nossa comunidade do InstructLab, conheça nossa IU upstream (um subconjunto dessas funcionalidades estará disponível lá) e compartilhe sua opinião. Adoraríamos nos conectar com usuários como você.

Sobre os autores

Design is a team sport, and as a principal designer on the Red Hat UXD team, Missy works closely with teams to solve complex problems and design meaningful, inclusive experiences. She joined Red Hat in January 2021. Currently, Missy is focused on RHEL AI and InstructLab, aiming to bridge the gap between the highly technical world of AI and less technical users.

Navegue por canal

Automação

Últimas novidades em automação de TI para empresas de tecnologia, equipes e ambientes

Inteligência artificial

Descubra as atualizações nas plataformas que proporcionam aos clientes executar suas cargas de trabalho de IA em qualquer ambiente

Nuvem híbrida aberta

Veja como construímos um futuro mais flexível com a nuvem híbrida

Segurança

Veja as últimas novidades sobre como reduzimos riscos em ambientes e tecnologias

Edge computing

Saiba quais são as atualizações nas plataformas que simplificam as operações na borda

Infraestrutura

Saiba o que há de mais recente na plataforma Linux empresarial líder mundial

Aplicações

Conheça nossas soluções desenvolvidas para ajudar você a superar os desafios mais complexos de aplicações

Virtualização

O futuro da virtualização empresarial para suas cargas de trabalho on-premise ou na nuvem