Bei den Releases unserer Produkte priorisiert das User Experience Design Team von Red Hat (UXD) die Implementierung von Arbeiten, die in direktem Zusammenhang mit Feedback und Insights von Kunden stehen. Für ein neues Produkt wie RHEL AI mussten wir kreativ werden. Zu den Feedback-Kanälen, die wir für dieses bevorstehende Release verwendet haben, gehören die Mitarbeit der Upstream Community und direktes Feedback von Nutzenden über Slack, Interviews mit internen Teammitgliedern, Interviews mit KI-Nutzenden und Enthusiasten, die an einer Einführung von RHEL KI interessiert sein könnten, sowie Prüfungen unserer Wettbewerbslandschaft. Dadurch konnten wir unsere Designarbeit für das Release RHEAL AI 1.4 und darüber hinaus verbessern.

Wir freuen uns, Ihnen einige neue wichtige Funktionen vorstellen zu können:

- Dokumentenkonvertierung: Ermöglicht die automatische Konvertierung hochgeladener Dateien in Markdown-Dateien. Nutzerinnen und Nutzer können nun PDFs, HTML-, ASCII-Dokumente usw. hochladen, die in Markdown konvertiert werden.

- Model-Chat-Bewertung: ermöglicht Nutzenden, die Antworten des Modells zu bewerten.

Contribution Experience

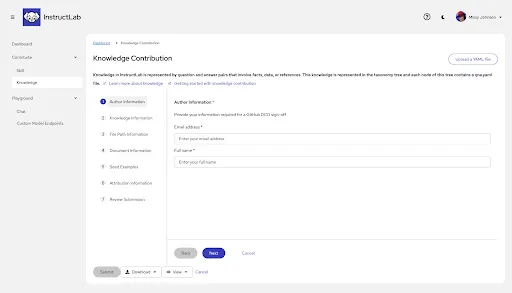

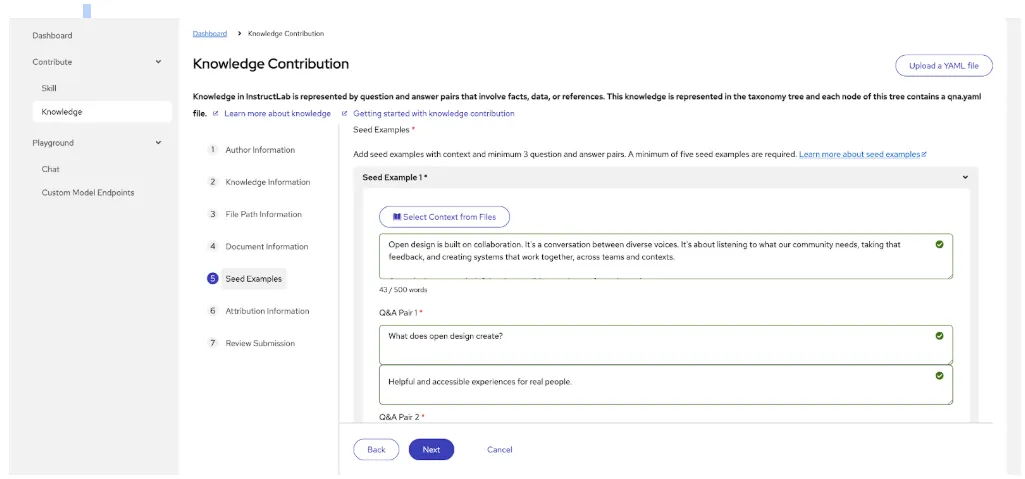

Die Contribution Experience, jetzt in der Dev Preview, ist eine grafische Benutzeroberfläche (GUI), die entwickelt wurde, um Fachleuten dabei zu helfen, Beiträge für ihre Wissensübermittlung zu erstellen, ohne YAML verstehen zu müssen. So wird die Hürde für technisches Fachwissen gesenkt, das erforderlich ist, um Wissen einzubringen und die Modellantworten zu verbessern. Mehr Kontext und Hintergrundinformationen finden Sie in diesem Blog, der im Dezember von unseren Kollegen aus dem Engineering-Bereich geschrieben wurde.

Im Folgenden sehen wir einige konkrete Beispiele für Bereiche, die wir für die Entwicklungsvorschau verbessert haben.

Formatierung

Was wir gehört haben:

Die Bearbeitung von YAML bleibt ein großes Problem, wobei das fortlaufende Feedback der meisten Nutzenden die Herausforderungen verdeutlicht. Die Navigation ist für technisch nicht so versierte Fachkräfte besonders schwierig. Die gesamte Dateneingabe ist schwierig. Außerdem ist nicht immer klar, was erforderlich und was optional ist. So kommt es häufig zu Fehlern durch falsche Einrückungen, nachgestellte Leerzeichen usw.

Unsere Antwort für 1.4:

Wir iterieren und verbessern die Benutzeroberfläche für den Wissensbeitrag und reduzieren so Reibungspunkte, ohne die Antworten und Leistung der Modelle zu beeinträchtigen. In dieser nächsten Iteration wurde von UXD empfohlen, die Langform in einen Assistenten zu ändern, um die Nutzenden durch den Prozess zu führen und Vertrauen darin zu gewinnen, dass bei jedem Schritt Fortschritte gemacht werden.

Außerdem werden Dokumente beim Hochladen automatisch in Markdown konvertiert.

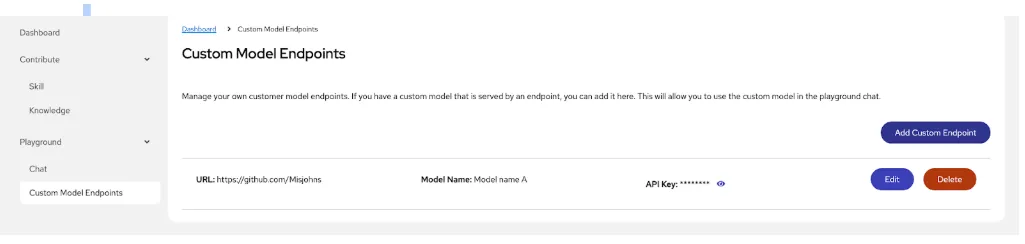

Hinzufügen eines Endpunkts zum Chatten mit einem Modell

Damit Nutzende mit ihren eigenen benutzerdefinierten Modellen kommunizieren können, arbeiten wir kontinuierlich an der Verbesserung des Endpunkterlebnisses bei benutzerdefinierten Modellen.

Für den Zugriff auf benutzerdefinierte Modelle müssen die Nutzenden einen dedizierten „Chat“-Endpunkt innerhalb der Plattform einrichten. So können Nachrichten in einem Gesprächsformat gesendet und Antworten empfangen werden, die den Kontext während der gesamten Interaktion beibehalten. Dazu müssen das gewünschte Modell, die Authentifizierungsdetails und die API-Endpunkt-URL angegeben werden, an die Anfragen für Chat-Interaktionen gesendet werden sollen.

Was wir gehört haben:

In unserer ersten Iteration fehlte der Liste der erstellten Endpunkte (Listenansicht genannt) ein hilfreicher Kontext, damit Nutzende die Funktionen des Endpunkts erfolgreich verwenden und mit ihren benutzerdefinierten Modellen kommunizieren konnten. Außerdem gab es keinen eindeutigen Zusammenhang zwischen dem Chat und dem Modellerlebnis. Daher wurden wir gebeten, die Workflows näher zusammenzubringen.

Verbesserungen, die wir für die Zukunft in Betracht ziehen:

- Status der Zustandsprüfung: Hinzufügen einer Spalte mit dem Status der Zustandsprüfung, damit Nutzende Probleme mit der Verfügbarkeit ihrer Endpunkte schnell erkennen können.

- Actions: Hinzufügen einer Schaltfläche, mit der Nutzende ihre Endpunktverbindung schnell aktivieren oder deaktivieren können. Bereitstellen eines Überlaufmenüs mit einem PatternFly kabob-Symbol für Edit und Delete.

- Details: Hinzufügen einer Seitenleiste, die geöffnet werden kann, um zusätzliche Details wie den Zeitpunkt der letzten API-Schlüsseländerung und einen Link zum Taxonomiepfad anzuzeigen.

- URL: Hinzufügen eines Kopiersymbols, mit dem Nutzende die URL schnell kopieren können.

- Default Sort: Hinzufügen der Möglichkeit, nach zuletzt erstellten Einträgen ganz oben zu sortieren

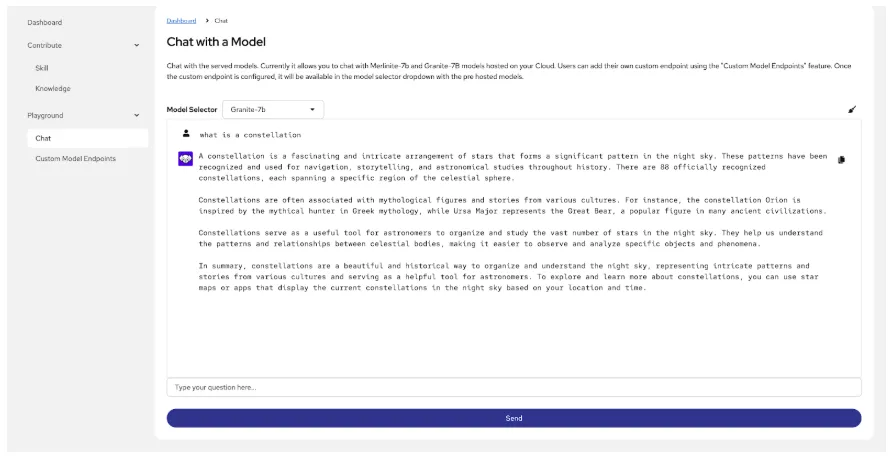

Chatten mit einem Modell

Es gibt viele Zeitpunkte, an denen Nutzende mit einem Modell kommunizieren möchten. Ein Beispiel:

- Um Lücken in den Modellantworten besser verstehen zu können, benötigen sie eine Antwort auf die Frage: Verfügt das Modell über die Daten, nach denen ich suche?

- Zum Vergleich der Antworten des Basismodells mit Antworten von benutzerdefinierten Modellen auf die Frage: Habe ich das Modell verbessert?

Letztendlich möchten Nutzende möglicherweise ein Basismodell, ein feinabgestimmtes Modell, das mit den Fine Tuning-Funktionen von InstructLab angepasst wurde, und ein optimiertes InstructLab-Modell in Kombination mit unseren RAG-Funktionen vergleichen.

Was wir gelernt haben:

Die erste Iteration war ein sehr einfaches Chatbot-Erlebnis, bei dem keine Quellinformationen angezeigt und keine Maßnahmen zu Modellantworten ergriffen werden konnten, und das vom Workflow des Modellendpunkts isoliert war. Es fehlte auch die Möglichkeit der Umwandlung von Sprache in Text.

Unsere Antwort für 1.4:

Zu den Verbesserungen der Chat-Oberfläche gehört die Möglichkeit, einen benutzerdefinierten Modellendpunkt direkt über diesen Workflow hinzuzufügen.

Verbesserungen, die wir für die Zukunft in Betracht ziehen:

- Möglichkeit, die für die Antwort des Modells verwendeten Quellen zu überprüfen und entsprechende Maßnahmen zu ergreifen (Gefällt mir, Ablehnen, Kopieren, Herunterladen und Neu generieren)

- Verwenden von Audio zum Erstellen einer Nachricht, anstatt einer manuellen Eingabe

- Angebot zusätzlicher, kontextbezogener Hilfe

Nächste Schritte

Viele spannende Verbesserungen und neue Funktionen sind in Planung:

- Generierung und Training mit synthetischen Daten

- Bewertung des neuen fein abgestimmten Modells im Vergleich zum Basismodell

- Vollständiges End-to-End-Tuning ohne die Verwendung einer CLI

Kontaktieren Sie uns

Wir wachsen kontinuierlich und entwickeln unsere Verbesserungen für RHEL AI mit einer kundenorientierten Denkweise weiter. Weitere Verbesserungen finden Sie in zukünftigen Releases. Bitte melden Sie sich an, um an zukünftigen Forschungsprojekten teilzunehmen und teilen Sie Ihre Erfahrungen mit RHEL AI.

Treten Sie außerdem unserer InstructLab Community bei, sehen Sie sich unsere Upstream-Benutzeroberfläche an (ein Teil dieser Funktionen wird dort verfügbar sein) und äußern Sie Ihre Meinung. Wir würden uns freuen, mit Nutzenden wie Ihnen in Kontakt zu treten.

Über die Autoren

Design is a team sport, and as a principal designer on the Red Hat UXD team, Missy works closely with teams to solve complex problems and design meaningful, inclusive experiences. She joined Red Hat in January 2021. Currently, Missy is focused on RHEL AI and InstructLab, aiming to bridge the gap between the highly technical world of AI and less technical users.

Nach Thema durchsuchen

Automatisierung

Das Neueste zum Thema IT-Automatisierung für Technologien, Teams und Umgebungen

Künstliche Intelligenz

Erfahren Sie das Neueste von den Plattformen, die es Kunden ermöglichen, KI-Workloads beliebig auszuführen

Open Hybrid Cloud

Erfahren Sie, wie wir eine flexiblere Zukunft mit Hybrid Clouds schaffen.

Sicherheit

Erfahren Sie, wie wir Risiken in verschiedenen Umgebungen und Technologien reduzieren

Edge Computing

Erfahren Sie das Neueste von den Plattformen, die die Operations am Edge vereinfachen

Infrastruktur

Erfahren Sie das Neueste von der weltweit führenden Linux-Plattform für Unternehmen

Anwendungen

Entdecken Sie unsere Lösungen für komplexe Herausforderungen bei Anwendungen

Virtualisierung

Erfahren Sie das Neueste über die Virtualisierung von Workloads in Cloud- oder On-Premise-Umgebungen