In ogni versione dei nostri prodotti, il team User Experience Design (UDX) di Red Hat che progetta l'esperienza utente dà priorità all'implementazione di attività direttamente correlate al feedback e alle opinioni dei clienti. Per un prodotto emergente come RHEL AI, essere creativi è stato indispensabile. Per aiutarci a migliorare l'esperienza della versione in lavorazione, abbiamo utilizzato diversi canali di feedback, tra cui l'interazione con la community upstream, il feedback diretto degli utenti tramite Slack, le interviste con i membri del team interno e con utenti e appassionati di IA potenzialmente interessati all'adozione di RHEL AI, e infine l'esame dei competitor. Abbiamo così raccolto le informazioni necessarie per la progettazione della release RHEAL AI 1.4 e delle versioni successive.

Di seguito sono elencate alcune delle nuove funzionalità:

- Conversione di documenti: consente di convertire automaticamente i file caricati in markdown. Ora gli utenti possono caricare PDF, file HTML, documenti ASCII e così via, che verranno convertiti in markdown.

- Valutazione della chat del modello: consente agli utenti di valutare le risposte del modello

Esperienza di contribuzione

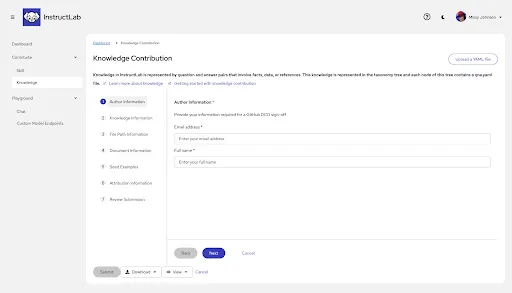

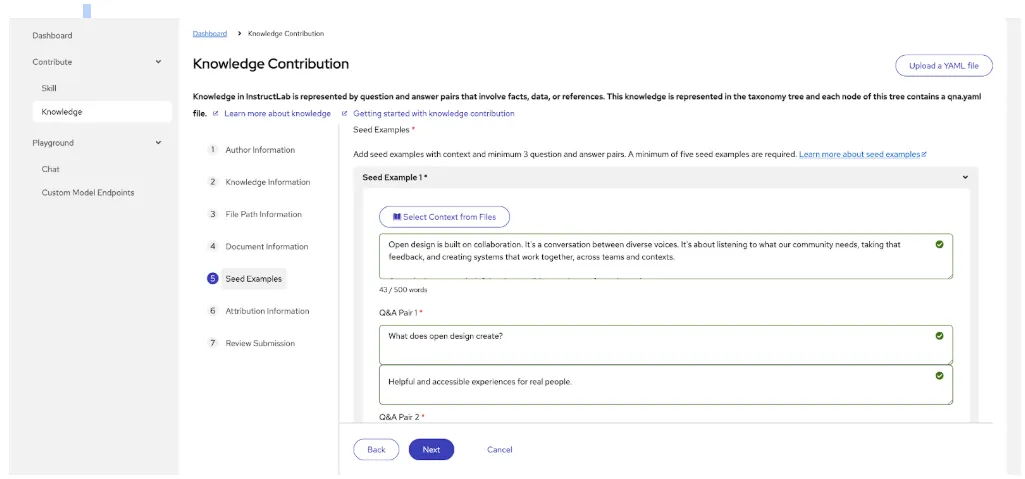

La funzionalità Contribution Experience, ora disponibile in anteprima per gli sviluppatori, è un'interfaccia utente grafica (GUI) creata per aiutare gli esperti di settore a creare input per contribuire con le proprie conoscenze senza dover conoscere il linguaggio YAML. La funzionalità permette di superare l'ostacolo delle competenze tecniche necessarie per offrire il proprio contributo e migliorare le risposte del modello. Per ulteriori informazioni, dai un'occhiata all'interessante blog scritto a dicembre dai nostri colleghi ingegneri.

Approfondiamo ora alcuni esempi specifici di aree sulle quali ci siamo concentrati per migliorare l'anteprima per gli sviluppatori.

Conoscenze di formattazione

I commenti degli utenti:

L'editing dei file YAML rimane un punto dolente, e i feedback continui della maggior parte degli utenti evidenziano le difficoltà. Sono soprattutto gli esperti di settore non tecnici a incontrare difficoltà. Nel complesso, l'attività di immissione dei dati è complicata e non è sempre chiaro cosa sia necessario e cosa sia facoltativo, il che spesso causa rientri errati, spazi vuoti iniziali o finali e altro.

Le nostre risposte per la versione 1.4:

Continuiamo a iterare per migliorare l'interfaccia utente e contribuire con le conoscenze, riducendo i punti di attrito senza incidere sulle risposte e sulle prestazioni del modello. Per la prossima iterazione, il team UXD ha consigliato di trasformare il modulo in una procedura guidata che accompagni gli utenti lungo il processo e garantisca il progresso dell'attività in ogni fase.

Inoltre, i documenti caricati vengono automaticamente convertiti in markdown.

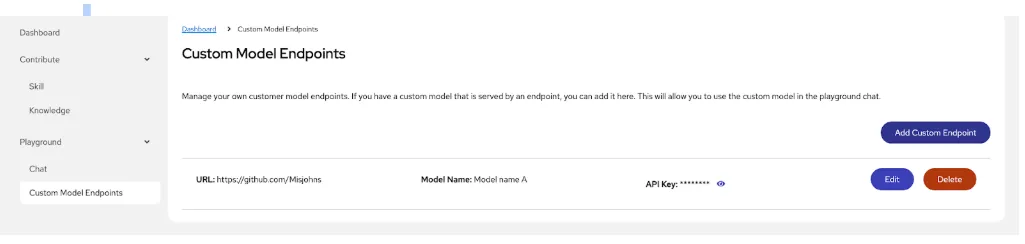

Aggiunta di un endpoint alla chat tramite un modello

Per consentire agli utenti di chattare con i propri modelli personalizzati, continuiamo a migliorare l'esperienza sugli endpoint dei modelli personalizzati.

Per accedere ai modelli personalizzati, gli utenti devono configurare un endpoint "chat" dedicato nella piattaforma, che permetterà di inviare messaggi in un formato colloquiale e di ricevere risposte adeguate al contesto durante l'interazione; per farlo, è necessario specificare il modello desiderato, i dettagli di autenticazione e dell'URL dell'endpoint API a cui inviare le richieste per interagire con la chat.

I commenti degli utenti

Nella prima iterazione, nell'elenco degli endpoint creato (denominato visualizzazione elenco) mancava il contesto utile per consentire agli utenti di sfruttare al meglio le funzionalità dell'endpoint e di chattare con i propri modelli personalizzati. Mancava inoltre una chiara connessione tra la chat e l'esperienza del modello; gli utenti ci hanno chiesto di avvicinare tra loro i flussi di lavoro.

Miglioramenti che stiamo valutando per il futuro

- Stato del controllo integrità: intendiamo aggiungere una colonna dello stato del controllo integrità per aiutare l'utente a identificare rapidamente i problemi legati alla disponibilità degli endpoint.

- Azioni: aggiungere un pulsante per consentire agli utenti di abilitare o disabilitare rapidamente la connessione all'endpoint. Fornire un menu aggiuntivo con un'icona kabob PatternFly per i comandi Edit e Delete.

- Dettagli: aggiungere un riquadro laterale che può essere aperto per visualizzare ulteriori dettagli, ad esempio la modifica più recente della chiave API, e un collegamento al percorso Taxonomy.

- URL: aggiungere un'icona di copia per consentire all'utente di copiare rapidamente l'URL.

- Ordinamento predefinito: aggiungere la possibilità di ordinare gli elementi partendo da quelli creati più di recente.

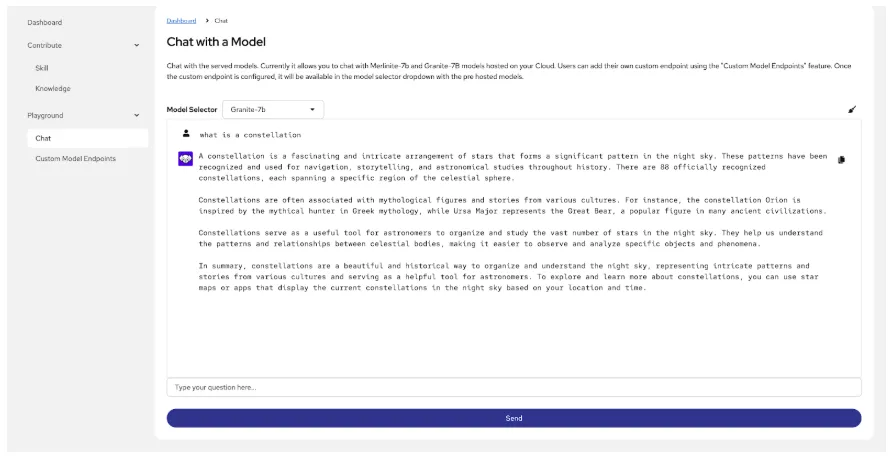

Chat con un modello

In molti punti nell'esperienza un utente potrebbe voler chattare con un modello. Ad esempio:

- Per capire meglio le lacune nelle risposte del modello, rispondendo alla domanda: "Il modello dispone dei dati che sto cercando?"

- Per confrontare le risposte del modello di base con le risposte del modello personalizzato, rispondendo alla domanda: "Ho migliorato il modello?"

Infine, un utente potrebbe voler confrontare un modello di base, un modello ottimizzato e personalizzato con le funzionalità di fine tuning di InstructLab e un modello ottimizzato di InstructLab combinato con le nostre funzionalità RAG.

Cosa abbiamo imparato:

La prima iterazione era un'esperienza di chatbot molto semplice, che non era in grado di visualizzare le informazioni sulla sorgente e di intervenire sulle risposte del modello; era inoltre isolata rispetto al flusso di lavoro dell'endpoint del modello. Mancava anche l'accessibilità della sintesi vocale.

Le nostre risposte per la versione 1.4:

Abbiamo migliorato l'interfaccia di chat includendo la possibilità di aggiungere un endpoint del modello personalizzato direttamente da questo flusso di lavoro.

Miglioramenti che stiamo valutando per il futuro

- Possibilità di esaminare le sorgenti utilizzate per la risposta del modello e di aggiungere una reazione (mi piace, non mi piace, copia, scarica, rigenera).

- Usare l'audio per creare un messaggio invece di digitarlo manualmente.

- Fornire ulteriore assistenza contestuale.

Le prossime novità

Sono in arrivo molti interessanti miglioramenti e nuove funzionalità:

- Generazione e addestramento di dati sintetici

- Valutazione del modello ottimizzato rispetto al modello base

- Ottimizzazione end-to-end completa senza la necessità di utilizzare una CLI

Contatta Red Hat

Il nostro approccio orientato al cliente fa sì che i miglioramenti apportati a RHEL AI siano in continua evoluzione. Non perderti quelli delle versioni future. Registrati per partecipare alle nuove ricerche e per condividere le tue esperienze con RHEL AI.

Entra nella nostra community InstructLab, dai un'occhiata all'interfaccia utente upstream (dove troverai un sottoinsieme delle funzionalità qui presentate) e condividi le tue opinioni. Saremo lieti di entrare in contatto con utenti come te.

Sugli autori

Design is a team sport, and as a principal designer on the Red Hat UXD team, Missy works closely with teams to solve complex problems and design meaningful, inclusive experiences. She joined Red Hat in January 2021. Currently, Missy is focused on RHEL AI and InstructLab, aiming to bridge the gap between the highly technical world of AI and less technical users.

Ricerca per canale

Automazione

Novità sull'automazione IT di tecnologie, team e ambienti

Intelligenza artificiale

Aggiornamenti sulle piattaforme che consentono alle aziende di eseguire carichi di lavoro IA ovunque

Hybrid cloud open source

Scopri come affrontare il futuro in modo più agile grazie al cloud ibrido

Sicurezza

Le ultime novità sulle nostre soluzioni per ridurre i rischi nelle tecnologie e negli ambienti

Edge computing

Aggiornamenti sulle piattaforme che semplificano l'operatività edge

Infrastruttura

Le ultime novità sulla piattaforma Linux aziendale leader a livello mondiale

Applicazioni

Approfondimenti sulle nostre soluzioni alle sfide applicative più difficili

Virtualizzazione

Il futuro della virtualizzazione negli ambienti aziendali per i carichi di lavoro on premise o nel cloud